- Что такое файл robots.txt?

- Нужен ли файл robots.txt для сайта WordPress?

- Нужен. И вот почему.

- Как выглядит файл robots.txt?

- Как создать файл robots.txt в WordPress?

- Создание и редактирование файла robots.txt с помощью плагинов All-in-OneSEO и YoastSEO

- Создание, редактирование файла robots.txt вручную

- Как проверить файл robots.txt?

Файл robots.txt для SEO–это тема разговора на сегодня.

Файл сообщает поисковым системам, как сканировать ваш сайт, что делает его невероятно мощным инструментом SEO.

В этой статье показано, как создать файл robots.txt для SEO.

Что такое файл robots.txt?

Robots.txt — это текстовый файл, который владельцы сайтов могут создать, чтобы сообщить роботам поисковых систем, как сканировать и индексировать страницы на их сайте.

Обычно он хранится в корневом каталоге, также известном как основная папка сайта.

В файле может быть несколько строк инструкций, разрешающих и запрещающих просмотр определенных URL-адресов и данные карты сайта.

Если вы не запретите URL-адрес, поисковые роботы будут считать, что им разрешено его сканировать.

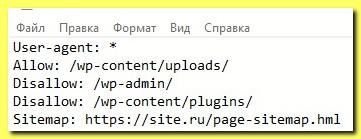

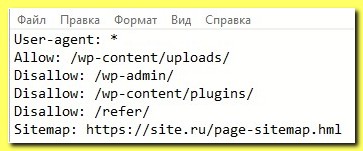

Вот как может выглядеть пример файла robots.txt:

В приведенном выше примере файла robots.txt мы разрешили поисковым системам сканировать и индексировать файлы в нашей папке загрузок WordPress.

После этого мы запретили поисковым ботам сканировать и индексировать плагины и папки администратора WordPress.

Наконец, мы предоставили URL-адрес нашей XML-карты сайта.

Нужен ли файл robots.txt для сайта WordPress?

Если у вас нет файла robots.txt, поисковые системы все равно будут сканировать и индексировать ваш сайт.

Однако вы не сможете указать поисковым системам, какие страницы или папки им не следует сканировать.

Отсутствие файла robots.txt не окажет большого влияния, если вы только начинаете вести блог и у вас мало контента.

Но однако по мере того, как ваш сайт будет расти и у вас появится много контента, у вас появится желание лучше контролировать процесс сканирование и индексирование сайта.

Нужен. И вот почему.

Поисковые боты имеют квоту сканирования для каждого сайта.

Это означает, что они сканируют определенное количество страниц во время сеанса сканирования.

И если они не завершат сканирование всех страниц сайта, они вернутся и возобновят сканирование в следующем сеансе.

Это может замедлить индексацию сайта.

Вы можете исправить это, запретив поисковым роботам сканировать ненужные страницы, такие как страницы администратора WordPress, файлы плагинов и папку тем.

Запрещая ненужные страницы, вы сохраняете квоту сканирования.

Это помогает поисковым системам сканировать еще больше страниц на сайте и индексировать их быстрее.

Еще одна веская причина использовать файл robots.txt — это ваше нежелание, чтобы поисковые системы индексировали определенный пост или страницу на сайте.

Это не самый безопасный способ скрыть контент от широкой публики, но он поможет вам предотвратить его появление в результатах поиска.

Как выглядит файл robots.txt?

Многие популярные блоги используют простые файлы robots.txt.

Содержание файлов может варьироваться в зависимости от потребностей конкретного сайта.

К примеру, такое:

Это содержимое файла говорит поисковым ботам, что надо индексировать все изображения и файлы WordPress.

Этот файл robots.txt запрещает поисковым ботам индексировать панель администратора WordPress, файл readme и скрытые партнерские ссылки.

Добавляя карты сайта в файл robots.txt, вы упрощаете роботам поиск всех страниц на сайте.

Теперь, когда вы знаете, как должен выглядеть файл robots.txt, давайте посмотрим, как создать файл robots.txt в WordPress.

Как создать файл robots.txt в WordPress?

Есть два способа создать файл robots.txt в WordPress, вручную и с использованием плагинов.

Вы можете выбрать метод, который лучше всего подходит для вас.

Создание и редактирование файла robots.txt с помощью плагинов All-in-OneSEO и YoastSEO

All-in-One SEO

All-in-One SEO, также известный как AIOSEO, является одним из лучших SEO-плагинов WordPress на рынке, который используется более чем на 2 миллионах сайтов.

Он прост в использовании и поставляется с генератором файлов robots.txt.

Примечание. Доступна бесплатная версия AIOSEO с этой функцией.

После установки и активации плагина вы можете использовать его для создания и редактирования файла robots.txt непосредственно из области администрирования WordPress.

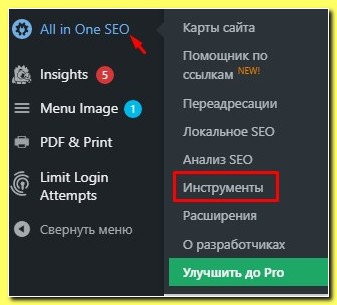

Просто перейдите в All in One SEO «Инструменты» для редактирования файла robots.txt.

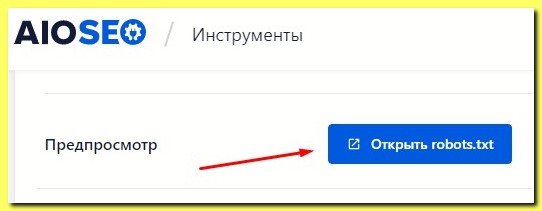

Сейчас вам нужно включить редактирование, щелкнув переключатель синего цвета «Открыть robots.txt».

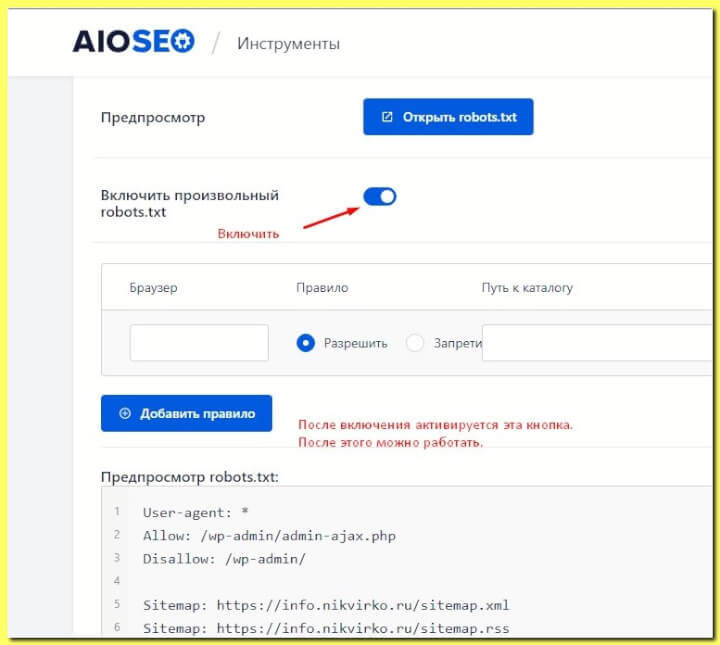

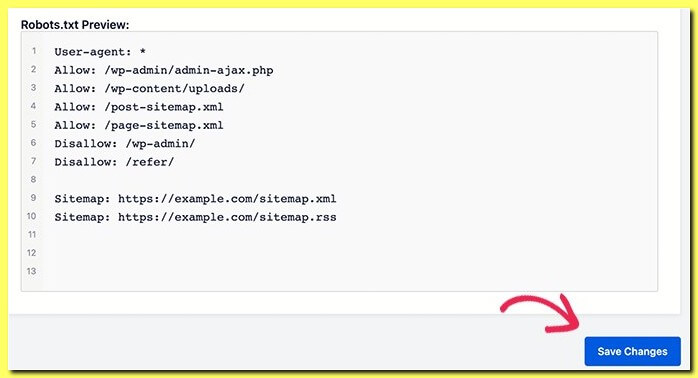

All in One SEO покажет ваш существующий файл robots.txt в разделе «Предварительный просмотр Robots.txt» в нижней части экрана.

Включив этот переключатель, вы можете создать собственный файл robots.txt в WordPress.

В этой версии файла будут отображаться правила по умолчанию, то есть добавленные самим WordPress.

И теперь вы можете добавить в него свои собственные правила, чтобы улучшить файл robots.txt для SEO.

Для этого сделайте то, что указано на картинке:

Чтобы добавить правило, введите пользовательский агент в поле «Пользовательский агент». Использование * применит правило ко всем пользовательским агентам.

Затем выберите, хотите ли вы «Разрешить» или «Запретить» поисковым системам сканирование.

После чего введите имя файла или путь к каталогу в поле «Путь к каталогу».

Правило будет автоматически применено к вашему файлу robots.txt.

Чтобы добавить другое правило, нажмите кнопку «Добавить правило».

Рекомендую добавлять правила до тех пор, пока вы не создадите соответствующий сайту формат файла robots.txt.

Ваши простейшие пользовательские правила будут выглядеть примерно следующим образом.

Когда вы закончите, не забудьте нажать кнопку «Сохранить изменения», чтобы сохранить все изменения в файле.

Следует отметить и такую отличительную особенность плагина All in One SEO Pack, как настраиваемую блокировку вредоносных ботов, которые сайт перегружают, а пользы от них нет никакой.

Yoast SEO

Сейчас, когда вы примерно поняли, что нам требуется коротко о создании файла robots.txt с использованием плагина Yoast SEO.

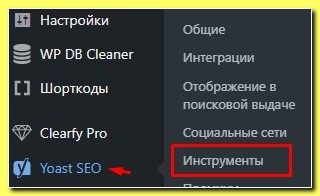

Устанавливаем и активируем плагин Yoast SEO.

Активировав плагин переходим в раздел “Инструменты”

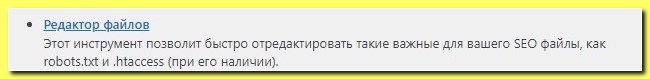

Здесь выбираем “Редактор файлов”

Далее нажимаем “Создать файл robots.txt”

На открывшейся странице можно составлять список команд для ботов поисковых систем или редактировать уже существующие данные.

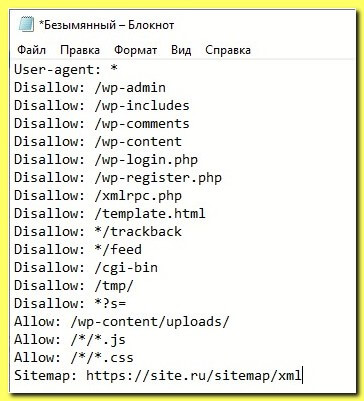

Файл robots.txt у вас может получиться примерно такой.

Посмотрев этот пример, вы поймете, как он создается и для вас уже не составит труда сделать его под свой сайт.

Здесь мы применили следующие команды поисковым ботам:

— указываем адресата команд (это User-agent)

— Закрываем от индексации (Disallow-закрытие):

- файлы админки;

- личные кабинеты, формы авторизации, регистрации;

- инструменты для работы с заказами (формы для заполнения данных, корзина и т. д.);

- данные поиска;

- служебные страницы;

- дублирующие страницы, разделы;

- данные о параметрах фильтрации, правил сортировки и сравнения;

- UTM метки;

- плагины и графику темы оформления сайта;

— Открываем (это Allow) те документы и файлы, которые находятся внутри закрытых категорий, но их индексация нам необходима.

Это могут быть JavaScript, изображения.

— вводим данные карты сайта (это Sitemap).

Завершив заполнение и используя сервисы Google и Яндекс проверяем правильность написания файла robots.txt

Создание, редактирование файла robots.txt вручную

Robots.txt — это обычный текстовый файл, что означает, что вы можете создать его на своем компьютере с помощью любого текстового редактора, такого как Блокнот, Notepad++ или TextEdit.

В принципе в предыдущем разделе мы создали неплохой файл robots.txt. Можно использовать его, либо его отредактировать под контент сайта.

И нам только остается на основе его создать виртуальный файл robots.txt либо разместить созданный файл в корневую папку сайта, используя возможности хостинга.

Как проверить файл robots.txt?

После создания файла robots.txt всегда рекомендуется протестировать его с помощью инструмента для проверки robots.txt.

Существует множество инструментов для тестирования robots.txt, но я рекомендую использовать тот, который находится внутри Google Search Console или в Яндекс Вебмастере. Мы же работаем с этими сервисами.

Для этого нужно связать свой сайт с Google Search Console, Яндекс Вебмастером.

Если вы еще этого не сделали, сделайте.

Затем вы можете использовать инструменты тестирования файла robots.txt указанных сервисов.

Надеюсь, что эта статья помогла вам оптимизировать файл robots.txt WordPress для SEO своего сайта.

PS: Если вы хотите более подробно изучить файл robots.txt рекомендую ознакомиться с этими материалами:

— Как Google интерпретирует спецификацию robots.txt

https://developers.google.com/search/docs/crawling-indexing/robots/intro?hl=ru

Использование файла robots.txt (Яндекс)

https://yandex.ru/support/webmaster/controlling-robot/robots-txt.html

Если вам понравилась эта статья, посмотрите другие материалы

раздела “Создание сайта”.

Вы также можете найти меня в Вконтакте.